1.14. التعليم شبه الخاضع للإشراف#

التعليم شبه الخاضع للإشراف هي حالة

في مجموعة بيانات التدريب الخاصة بك، بعض العينات غير مصنفة.

يمكن لمقدرات التعليم شبه الخاضع للإشراف في sklearn.semi_supervised

استخدام هذه البيانات غير المصنفة الإضافية لالتقاط شكل توزيع البيانات الأساسي بشكل أفضل

وتعميم أفضل للعينات الجديدة.

يمكن لهذه الخوارزميات أن تؤدي أداءً جيدًا عندما يكون لدينا كمية صغيرة جدًا من

النقاط المصنفة وكمية كبيرة من النقاط غير المصنفة.

ملاحظة

تحتاج خوارزميات التعليم شبه الخاضع للإشراف إلى افتراضات حول توزيع مجموعة البيانات من أجل تحقيق مكاسب في الأداء. راجع هنا لمزيد من التفاصيل.

1.14.1. التدريب الذاتي#

يستند هذا التنفيذ للتدريب الذاتي إلى خوارزمية Yarowsky [1]. باستخدام هذه الخوارزمية، يمكن لمصنف مشرف معين أن يعمل كمصنف شبه مشرف، مما يسمح له بالتعلم من البيانات غير المصنفة.

يمكن استدعاء SelfTrainingClassifier مع أي مصنف ينفذ

predict_proba، ويمرر كمعلمة base_classifier. في

كل تكرار، يتنبأ base_classifier بالتصنيفات للعينات غير المصنفة

ويضيف مجموعة فرعية من هذه التصنيفات إلى مجموعة البيانات المصنفة.

يتم تحديد اختيار هذه المجموعة الفرعية بواسطة معيار الاختيار. يمكن إجراء هذا

الاختيار باستخدام threshold على احتمالات التنبؤ، أو

باختيار k_best العينات وفقًا لاحتمالات التنبؤ.

تتوفر التصنيفات المستخدمة للتجهيز النهائي وكذلك التكرار الذي تم فيه تصنيف كل عينة

كميزات. تحدد المعلمة الاختيارية max_iter عدد المرات التي يتم فيها تنفيذ الحلقة كحد أقصى.

قد يتم تعيين معلمة max_iter إلى None، مما يتسبب في تكرار

الخوارزمية حتى يتم تصنيف جميع العينات أو عدم تحديد عينات جديدة في هذا التكرار.

ملاحظة

عند استخدام مصنف التدريب الذاتي، calibration للمصنف مهم.

أمثلة

المراجع

1.14.2. انتشار التصنيف#

يشير انتشار التصنيف إلى بعض التباينات في خوارزميات الاستدلال الرسومي شبه المشرف.

- تتوفر بعض الميزات في هذا النموذج:

تستخدم لمهام التصنيف

أساليب النواة لمشروع البيانات في مساحات الأبعاد البديلة

يوفر scikit-learn نموذجين لانتشار التصنيف:

LabelPropagation و LabelSpreading. كلاهما يعمل من خلال

بناء رسم بياني للتشابه عبر جميع العناصر في مجموعة البيانات المدخلة.

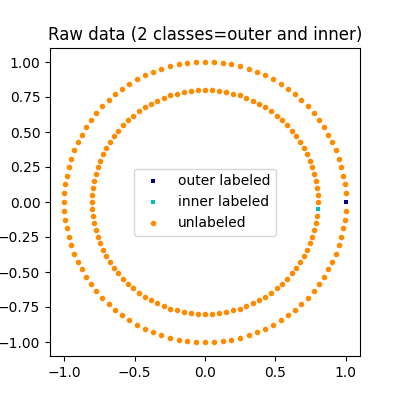

توضيح انتشار التصنيف: يتسق هيكل الملاحظات غير المصنفة مع هيكل الفئة، وبالتالي يمكن نشر فئة التصنيف إلى الملاحظات غير المصنفة لمجموعة التدريب.#

يختلف LabelPropagation و LabelSpreading

في التعديلات على مصفوفة التشابه التي يتم رسمها والآثار المقيدة على توزيعات التصنيف.

يسمح التقييد للخوارزمية بتغيير وزن البيانات المصنفة الحقيقية إلى حد ما. يقوم خوارزمية LabelPropagation بتقييد صعب لإدخالات التصنيف، مما يعني \(\alpha=0\). يمكن استرخاء هذا عامل التقييد، ليقول \(\alpha=0.2\)، مما يعني أننا سنحتفظ دائمًا

بنسبة 80 في المائة من توزيع التصنيف الأصلي، ولكن الخوارزمية تحصل على تغيير ثقتها في التوزيع ضمن 20 في المائة.

يستخدم LabelPropagation مصفوفة التشابه الخام التي تم إنشاؤها من

البيانات دون تعديلات. على العكس من ذلك، يقلل LabelSpreading

من دالة الخسارة التي لها خصائص تنظيمية، وبالتالي فهي غالبًا أكثر مقاومة للضوضاء. تقوم الخوارزمية بتكرار الإصدار المعدل من الرسم البياني الأصلي وتطبيع أوزان الحواف عن طريق

حساب مصفوفة لابلاسيان الرسم البياني المعياري. يتم استخدام هذا الإجراء أيضًا في التجميع الطيفي.

تتوفر في نماذج انتشار التصنيف طريقتان مدمجتان للنواة. يؤثر اختيار النواة على كل من قابلية التوسع وأداء الخوارزميات. فيما يلي ما هو متاح:

rbf (\(\exp(-\gamma |x-y|^2), \gamma > 0\)). \(\gamma\) يتم تحديدها بواسطة الكلمة الرئيسية gamma.

knn (\(1[x' \in kNN(x)]\)). \(k\) يتم تحديدها بواسطة الكلمة الرئيسية n_neighbors.

ستنتج نواة RBF رسمًا بيانيًا متصلًا بالكامل يتم تمثيله في الذاكرة بمصفوفة كثيفة. قد تكون هذه المصفوفة كبيرة جدًا، بالإضافة إلى تكلفة إجراء عملية ضرب المصفوفة الكاملة في كل تكرار للخوارزمية، مما قد يؤدي إلى أوقات تشغيل طويلة للغاية. من ناحية أخرى، ستنتج نواة KNN مصفوفة نادرة أكثر ملاءمة للذاكرة والتي يمكن أن تقلل بشكل كبير من أوقات التشغيل.

أمثلة

المراجع

Yoshua Bengio، Olivier Delalleau، Nicolas Le Roux. في التعليم شبه الخاضع للإشراف (2006)، الصفحات 193-216

Olivier Delalleau، Yoshua Bengio، Nicolas Le Roux. فعال

غير معلم وظيفة الاستقراء في التعليم شبه الخاضع للإشراف. AISTAT 2005 https://www.gatsby.ucl.ac.uk/aistats/fullpapers/204.pdf